Bonjour à tous,

Il y a des moments dans la vie où il faut savoir reconnaître ses limites. Et là, je crois que j'ai atteints les miennes sur un point technique.

Or, L'Air du Bois est avant tout un espace où la force est dans le collectif. C'est pourquoi, je fais appel à vous aujourd'hui !

Le problème

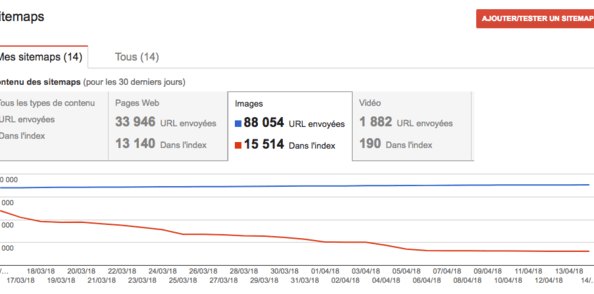

Depuis à peu près le 15 mars, Google désindexe bon nombre de pages et surtout d'images de L'Air du Bois qu'il avait lentement mais surement mis 5 ans à engranger (cf image de ci-dessus).

C'est un problème pour la visibilité du site. A peu près 30% du trafic journalier vient de ces nouveaux visiteurs qui découvrent votre travail grâce à son indexation dans Google.

Aujourd'hui cette source de trafic a diminué et je ne m'explique pas pourquoi.

A l'Aide

Je fais donc appel à ceux qui parmi vous sont plutôt calé en SEO (Search Engine Optimization) pour essayer de trouver des réponses. Qu'est que j'aurais pu faire de travers ? Qu'est-ce qu'il faudrait améliorer ? ... etc ...

Pourquoi avoir attendu 1 mois ?

En terme de SEO, tout est long et prend du temps. Ce que je pensais avoir mis en place ne semble pas porté ses fruits. Et puis ce n'est pas une information qu'on regarde tous les jours ;)

Par ailleurs, j'ai beaucoup de projets chronophages en ce moment sur mon activité.

Qu'est-ce qui est en place ?

- Le site est enregistré sur la Search Console de Google (anciennement Webmaster Tools) depuis 2013 pour le lien en http et mars 2018 pour le lien en https

- Le sitemap du site est envoyé à Google et inscrit dans le robot.txt. C'est en fait un sitemap d'index qui donne les liens vers les sitemaps secondaires.

- Les sitemaps secondaires (propre à chaque rubrique) sont générés automatiquement toutes les 24h.

- Les images et vidéos d'un contenu sont intégrés aux sitemaps. Pour les images, le lien vers l'image en 1024x1024 est considéré ici.

- Les images envoyées par les utilisateurs sont toutes reprisent par le serveur pour les renommer avec un hash unique et mise en cache sur le serveur. (A ce jour, le serveur compte environ 77 000 images. Je ne sais pas pourquoi Google en reçoit 88 000.).

- Exemple : 48e194bd1103ecbffd6f665533345bd7c3158875.jpg. Ca c'est pas cool pour le référencement, mais ça permet de certifier qu'il n'y a pas de doublon.

- Les images sont redimensionnées à plusieurs tailles (pour correspondre au mieux à la taille affichée).

- Les images sont optimisées par le serveur lors de la création de chaque taille (optimisation de la compression PNG et JPEG) grâce à pngquant, optipng et jpegoptim

- Dans le source HTML de la page, les images principales d'une publication ont un ALT équivalant à la légende que l'utilisateur a mis sur l'image. S'il n'y a pas de légende, c'est le titre de la publication qui est pris en compte.

- Quasiment toutes les pages de contenu intègrent les données structurées au format schema.org.

- Le serveur compresse (GZIP) les pages html à la volée.

- Le cache côté navigateur sur les images (jpeg uniquement), les css et les js est actif

- Le site intègre la syntaxe OpenGraph de Facebook pour décrire les pages.

- Le site est responsive (il s'adapte aux mobiles et tablettes)

- Les fichier CSS et JS sont minifiés.

- Toutes les page de listes (comme Créations) ont un chargement dynamique en fonction du défilement de l'écran. Pour que les moteurs de recherche ne soient pas perdu dans cette fausse pagination, il y a les balise <link rel="prev" ...> et <link rel="next" ...> dans le header et en bas de page. Ces balises offrant aux moteurs de recherche le lien vers la page précédente et suivante.

- Le site est servi en HTTP/2

Votre aide ?

Alors voilà, si vous aimer L'Air du Bois et ce qu'il représente, merci de votre aide !

Questions sans réponses

Voici diverse questions pour lesquelles je veux bien vos lumières ;)

URL Canoniques

Pour les publications type créations, plans, etc ... j'ai fait en sorte que l'URL canonique soit avec seulement l'identifiant numérique du contenu. Exemple :

. Ceci afin d'être certain que l'URL canonique reste invariante même si le titre de la publication est modifié.- Sachant que désormais Google ne considère que les URL canoniques, est-il bon d'avoir une URL canonique qui ne contient pas le titre de la page ?

Breadcrumb

- Est-il possible que Google considère le Breadcrumb (défini dans les balises meta) même s'il n'a qu'un niveau et n'est affiché ici que par le menu latéral à gauche ?

Boris

Bricodeur du dimanche ...

PS : Si le seul terme SEO ne vous parle pas du tout, parlez-en autours de vous. Il y aura forcément un bon copain qui aura à répondre là dessus ;)

EDIT 26 avril 2018

Les choses changent

Discussions

Désolé Boris, ça me dépasse de beaucoup ces choses là...

Arf, merci Olivier d'avoir pris le temps de lire ce sujet quand même ;)

cousin06Désolé je ne comprends rien à seo

Plus simple de faire des meuble lol

Désolé Boris, peu de notion pour avoir des idées constructives

Bonjour Boris

J aurai bien proposé mon aide mais je galère déjà à utiliser sketchup correctement donc ce n'est pas gagné pour moi ( un peu d'humour dans ce monde de brute). Le seul conseil que je pourrai te donner, c'est de faire appel à un webmaster (hélas je n'en connais pas, je suis d'une grande aide ça se voit).

En espérant que la situation s'améliore bonne journée

Plus qu'un webmaster, c'est un expert SEO qu'il faut ici.

La sous question à mon message ici est de savoir si parmi la communauté de ceux qui consultent L'Air du Bois, il y en a ;)

Et si oui, est-ce qu'ils pourraient avoir un avis éclairé sur la question.

Avec le temps, je pense être bien monté en compétences sur la question. Mais comme toute activité, il est toujours préférable de confronter les idées avec plus compétant que soi, surtout quand on se trouve bloqué ;)

Il est certain que la fonction d'expert SEO, est une activité qui fait vivre bon nombre de gens dans le domaine du Web. Quelques cliques et on se paie les conseils d'un expert.

Loin de moi l'idée de chercher à faire tout sans jamais payer l'expert qui le vaudrait bien. Je pense juste qu'en premier lieu, il faut se demander si la personne ressource n'est pas déjà là ;)

Salut Zeloko, je ne comprends pas exactement la conséquence sur la fréquentation du site et l'accès des visiteurs occasionnels. Si tu peux avoir plus de précisions, je vais tâcher de diffuser afin d'avoir la solution ou en tout cas une aide éclairée.

Patrice

Salut Patrice,

C'est le point de découverte du site. Je ne pense pas me trompter pour dire que 90% d'entre vous on découvert L'Air du Bois en cherchant autre chose.

Le truc n'est pas de chercher absolument à avoir du trafic. C'est surtout que c'est ce trafic qui donne du sens au site. Mettre en ligne des choses aussi belles soit-elles n'a pas de sens si elles ne sont pas vues ;)

De mon point de vue, il n'y a pas UNE solution. Mais c'est une multitudes de petites actions à faire et de choses à éviter.

Merci pour la diffusion ;)

Bonjour Boris,

Je travaille dans le web et mon principal collaborateur est calé en SEO. On pourrait regarder si tu le souhaites mais il nous faudra sûrement quelques accès (WebMaster Tools, Analytics…). Intéressé ?

Wep, Intéressé !!

Bonjour a tous. Je ne vous aiderai pas,rien que les lettres SEO pour c'est du (charabia) mon PC fait non pas ce que je veux mais comme les chiens non dressés c'est lui qui me traine. Sinon j'aurai aimé. Mais je suis certain que certains trouverons la solution

à bientôt

peu malheureusement pas aidez désoler, si il y a une pétition je veut bien la signer

Bonjour ami(es) boiseux

Boris je t'adresse un message de soutien, et j'active mon réseau afin d'apporter une solution à cet épineux problème. ..

Tiens nous au courant.

A chaque problème sa solution.

Rv.

Bonjour,

Désolé c’est complètement hors de mes compétences et je ne sais pas comment faire pour t’aider car j’ai le même problème ailleurs.

A+

Serge

c'est incroyable voici une chaine de très haute qualité, que l'on embête, alors que certaines chaines ne mérite pas d'être sur le web bonne chance mais mois en informatique je n'y connaît rien

Arf, le référencement dans les moteurs de recherche n'est pas (toujours) une affaire de qualité. Il faut juste connaitre les bons secrets ... qui changement tout le temps ...

Un site très mauvais peut être très bien classé dans un moteur de recherche s'il s'y prend bien ;)

C'est le monde merveilleux des algorithmes.

hello, j'ai le droit de dire que je n'utilise plus google mais qwant... ok ça sert à rien. A part ça, en vrai, je suis prof en écolé d'ingé dans un groupe qui contient une école d'info... bref, je vais voir si je trouve des compétences et réponse à tes questions...

Oui, tient, sais tu si on peut connaître l'état de l'indexation dans Qwant ?

Merci ;)

En lisant ton article, je me suis posé la même question (je n'utilise plus google depuis longtemps).

Par contre, visiblement, on ne peut pas connaitre le niveau d'indexation sur Qwant...

Sinon pour le souci avec Google, je vais pas pouvoir faire grand chose de plus, bon courage en tout cas.

zeloko et non pour l’instant Qwant ne propose pas d’outil pour les développeurs. Pas de search console chez les français donc.

Boris je prend note de ton poste est je vais regarde ce que je peut trouver .................

Merci !

Cela veut peut-être tout simplement dire, qu'une fois de plus, google a modifié ses algorithmes, pas forcément que ton travail n'a pas porté ses fruits...

support.google...r/7451184?hl=fr

"Lorsque Google modifie un algorithme, le trafic dans l'une de nos filiales s'effondre à 70 % en quelques jours..." Axel Springer.

Hello Boris, je vais jeter un coup d'oeil également, même si ce type d'information est loin de la programmation que je maîtrise...

Comme dit plus haut, Google a pas changé une fois de plus ces robots?

Bonjour Boris, je me renseigne cette semaine avec la personne qui gère les sites du groupe pour qui je travaille.

Je ne garanti rien mais cela ne coûte rien de demander.

Bon dimanche.

Il s'agit peut-être d'un changement de l'algo de ranking pour les images. Le fait que le site ne soit pas un réseau social "connu" et que pour la plupart les images n'ont pas de description (me semble-t-il) pourraient induire qu'elles ne soient plus indexées, et que Google fasse récursivement le ménage dans ces anciens indexes ?

Un bon résumé sur le sujet : searchenginela...-results-278609

C'est fort probable. Mais je manque d'outils pour savoir quelles sont les images qu'il aurait gardé ;(

Ce que je sais et qui peut expliquer une partie du truc, c'est que les deux premières années du site, les images étaient en 800x700 (pour les plus grandes). Et qu'en suite, j'ai remonté la résolution à 1024x1024. Y a donc 3 ans que les liens vers les images 800x700 ne fonctionnent plus. Mais en même temps y a 3 ans, y avait aussi beaucoup moins d'images sur LADB. Je présume qu'une bonne partie des images indexée étaient donc déjà en 1024x1024

Sinon, pour info : dans les publications, les images n'ayant pas de légende ont un ALT qui correspond au titre de la création.

Salut à tous,

Merci à tous ceux qui s'efforcent de me donner des compléments de réponses.

Pour aider chacun, j'ai ajouté plus haut dans ce sujet une liste de Qu'est-ce qui est en place ?.

En espérant que ça pourra apporter d'autres pistes de recherches.

Ce qui compte le plus pour google, ce ne sont pas les sitemaps, mais le fait que les pages soient accessibles par liens directs ou indirects depuis la page principale du site.

Peut-être un problème avec le chargement dynamique des pages?

Oui, les sitemaps c'est surtout pour lui faire découvrir ce qui n'est pas (ou plus) accessible par la page d'accueil.

Tous les contenus sont accessibles par liens directs ici. Pour ce qui est de les rendre accessibles par la page d'accueil, ça me semble difficile de toutes façon, il y en a bien trop.

zeloko je voulais dire accessibles indirectement via la page d'accueil.

Je n'ai vu le site que sur mobile(!) et le chargement des pages y est progressif. Un moteur de recherche ne peut pas suivre ces liens a priori.

Mais je n'ai pas vu la version PC, ni le code des pages, alors je ne suis sûr de rien ;-)

En fait, il y a deux balises exprès dans les pages de liste pour que les moteur suivent la pagination.

dans les metas, il y a <link rel="prev" ... > et <link rel="next" ... >

Et cela sur mobile ou ordi.

Aurélien a juste ! Il faut que toutes les images soient accessibles depuis le site pas forcément depuis la home. Les sitemaps c’est plus pour accélérer la prise en compte et donc l’indexation des pages. D’ailleurs sur mes sites, les pages importantes sont dans un sitemap précis et ensuite j’ai un sitemap par catégorie qui récence juste les nouvelles pages pendant quelques jours. Une fois que Google les a prises en compte, si elles sont accessibles via des liens sur le site ou dans le code si c’est des images ça reste indexé (sauf problème particulier). Il faut savoir que Google a un quota de crawl définit pour chaque site. Si les sitemaps contiennent l’intégralité des pages ou images contenus dans le site, Googlebot pert quotidiennement sont temps à essayer de découvrir des choses qu’il connaît déjà. Mieux vaut lui filer que les nouvelles url...

clement66 mais du coup, tu penses qu'il est préférable de ne pas mettre tout le site dans les sitemaps ?

Mais qu'est-ce qu'une nouvelle URL ? Une page de moins de combien de temps ? Tout dépend de savoir si les moteurs l'ont déjà indexée, non ?

Quand tu as un site de 90000 pages, effectivement, je pense qu'il ne faut pas mettre toutes les pages dans les sitemaps.

Une nouvelle url c'est une url fraiche. Par exemple, une nouvelle création ou un nouvel utilisateur génère une nouvelle page/url.

Pour que GG indexe une nouvelle page, c'est l'histoire de quelques heures en théorie. Si tu lui laisses une semaine ou plus tu ne prends pas de risque.

Donc par exemple, tu as un sitemap blog qui liste les nouveaux articles. Tu fais une requête sur ta base qui liste les articles les plus récents (une semaine ou deux d'ancienneté). Et chaque fois que GoogleBot check ton sitemap, il redécouvre les urls récentes (derniers jours) et il découvre les nouvelles urls du jour.

Après c'est à toi de choisir la période. Pour un blog avec peu d'article, tu peux mettre les actus du mois ou des deux derniers mois.

Pour une rubrique comme les créations qui brasse beaucoup d'url, tu peux mettre deux semaines...

Pour la question : Tout dépend de savoir si les moteurs l'ont déjà indexée, non ?

Le moteur doit, si un site est bien conçu, découvrir les urls tout seul.

Encore une fois les sitemaps c'est un plus. Donc dans le cas ou ton url n'a pas été indexé en quelques jours via le sitemap. Si elle disparait du sitemap, l'url n'est pas perdu. Le bot doit pouvoir la trouver via le maillage.

Au passage, ça reste mon point de vue. D'autres sont plus favorables à mettre l'intégralité des urls dans les sitemaps...

Un dossier intéressant sur le sujet > webrankinfo.co...taux-indexation

A l'heure actuelle, les sitemaps de LADB sont générés toutes les 24h avec tout (y a même toutes les images et vidéos dans chaque publication). Voir le code.

C'est donc un truc à modifier ?

J'ajoute que tu peux vérifier les pages et images indexés mar Google en cherchant sur Google: "site:www.lairdubois.fr"

Wep, sinon, il y a aussi

Pour avoir le résultat d'une seule page.

Bonjour,

Ce serait pas la conséquence du passage à l'indexation mobile-first ?

Si la version mobile était moins bien référencée, ça pourrait coller avec ce que tu constate.

Google l'a annoncé il y a peu : webmasters.goo...t-indexing.html

Bon courage...

Je pense que l'adaptation modile de LADB n'est pas parfaite, mais elle doit remplir une bonne partie des critère quand même.

C'est peut-être sur le temps de chargement des pages que ça pèche ...

Et le problème dans tout ça, c'est que tu ne pas savoir si tu cherches dans la bonne direction puisque Google est encore plus muet que l'armée française et que pour faire des essais, il faut attendre des semaines pour en voir les effets.

:(

Et on est bien d'accord que la version mobile c'est entièrement géré par le responsive design du template ?

i.e. : pas de test côté serveur pour servir des contenus différents en fonction du device de l'utilisateur

On en parle évidemment sur Webrank, et je ne trouve pas ça très rassurant...

webrankinfo.co...03-2018.193154/

La vitesse ne semble pas si mauvaise :

developers.goo...w.lairdubois.fr

Oui

je passe !!! mais je vais suivre ! bon courage à ceux qui savent !

Tu n'aurais pas du JS qui se déclenche en cliquant sur les liens ? Je n'ai pas regardé la source mais il y a un comportement non standard ici lorsque j'ouvre un lien vers un nouvel onglet, je suis redirigé de force vers le nouvel onglet. Peut-être que Google considère que c'est à proscrire et blackliste ?

Le comportement que tu vois, c'est parce que j'ai voulu que toute la case soit cliquable, mais que pour autant, le nom de l'auteur aussi (et avec un autre lien). Or, il est dans la case. La case ne pouvait donc pas être un lien. Seule l'image est un lien.

C'est comme ça depuis le début, alors je me dis qu'à moins qu'il ait changé leur politique, ça n'aurait jamais référencé.

Essaye les actions proposées par : woorank.com/en...w/lairdubois.fr

et les 15 premiers jours à l'essai.

Merci, pas mal d'actions/correction que j'ai pu faire des dernières années sont issues des infos données par ce type d'analyseur.

Les images les mieux indexées pour mes clients, sont celle qui ont bien les mots clés dans le nom du fichier directement, mais dans le cas d'url avec uniquement chiffres, je remplis le TITLE et l'ALT absolument. En reprenant un mot clés commun aux deux balises, mais en les complétant entre l'une et l'autre.

Mais je ne suis pas sûr que cela vienne de ça bien sûr je pense que c'est encore autre chose. Mais voilà comment je fais pour bien ressortir.

Quel moteur/template utilises-tu ?

Aucun moteur. Le site est fondé sur le framework PHP Symfony, mais sinon pour le reste, c'est bibi qui a écrit le code.

Le rendu des pages est écrit en Twig.

bien joué! beau travail!

Perso, le nom de l’URL de l’image n’est pas primordial pour moi. C’est plus la balise alt et l’environnement (contenu) de la page qui contient l’image qui est important.

Sinon j'ai trouvé ceci aussi sur le net :

Préciser la licence de vos images

Depuis plusieurs années, Google Images permet de rechercher des images selon le droit d’usage qui y est attaché (Réutilisation autorisée, Réutilisation autorisée sans but commercial, etc.).

Si vos images offrent de telles possibilités, elles ont probablement été placées sous une licence Creative Commons ou GNU Free Documentation License. Pour l’indiquer, Google incite à procéder en utilisant la notation RDFa3.

Exemple pour la licence CC BY-SA :

<div about="image.png">

<img src="image.png" alt="Texte alternatif">

<a rel="license" href="creativecommon...nses/by-sa/2.0/">Licence CC BY-SA</a>

</div>

A tenter aussi de les intégrer dans une balise figure aussi…

A tenter en effet ;)

As-tu pensé aux écran haute résolution (rétina), une version plus large de base serait un plus aussi sur ses écrans. (sinon ça s'affiche un peu flou, plus qu'en 72dpi).

Je pense que google préfère le grosses images en haute qualité pour mieux servir ce genre d'écran haute résolution…

Si tu as des copies hautes résolution de ces images… n'hésite pas à les servir… je pense qu'au plus large (zoom) quelque chose comme 2000px et + serait pas mal… et environ 1500px pour les les non zoomées. (il faudrais faire les calculs en x2 x4 pour trouver les bonnes résolution en fonction de l'espace de tes images affichées)

Arf, non, au départ, je l'ai joué prudent pour préserver l'espace disque. Les images uploadées par les utilisateurs sont toutes redimensionnées au max en 1024x1024 pour être conservées en ressource sources.

C’est un très bon format. Si tu as plusieurs versions d’une image, faut en donner qu’une a GG. 1024x1024 est un peu le format passe partout donc c’est bien.

Le hic, c'est que les images en 1024 ne sont pas directement affichées sur les pages du site.

Bon c’est pas très grave. En tout cas le problème ne vient pas de là...

Salut,

Google à annoncer qu’il "favoriserait" les sites ayant une version canonique au format AMP , peut-être voir de ce côté-là ?

Sinon, j’ai regardé ton source, il particulièrement propre ! bravo :-)

juste une remarque qui génère quelques erreurs dans les moteurs d’indexation en général (surtout Bing ) c’est l’utilisation de la meta charset="UTF-8" dans le head et l’utilisation du charset="iso-8859-1" dans la balise alt d’une image.

Mais ceci n’a probablement rien à voir avec la dernière mise à jour de la logique métier de google qui désindexerait juste des images.

Cordialement,

Norbert

Arf, ça m'a semblé très contraignant l'AMP (enfin de ce que j'en ai vu ...). Et ça oblige de développer deux versions du site ;(

Merci !!

Arg, tu peux être plus précis, je suis pas certain de voir ce que tu veux dire ?

zeloko

l'entête de page (<head>..</head>) déclare le document html en UTF8 via le meta <meta charset="UTF-8" />

dans ton meta description tu utilise bien du UTF8 exemple <meta name="description" content="Bonjour à tous,

Il y a des moments dans la vie où il faut savoir reconnaître ses limites. Et là, je crois que j & #039 ; ai...... "

alors que sur tes alt et title non par exemple "<img src="....jpg" alt="Aurélien 34" ..." ou "<i .. title="Zeloko travaille dans les métiers du bois" >"

Cordialement,

Norbert

Arcantar : je pense qu'il y a une petite confusion.

Les pages sont bien servies et encodées en UTF8.

Les caractères remplacés par des séquences encadrés par des "&" et des des ";" sont des entités HTML.

Arcantar a mes yeux, le haut et le bas ne présentent pas de différence, si ?

Dans les deux cas, les accents ne sont pas encodés en HTML mais en UTF-8 (parce que mon fichier est en UTF-8). L'apostrophe, si, mais afin qu'elle ne soit pas en conflit avec le caractère délimiteur de chaîne du HTML.

Dalida exact mais :-) pour les moteurs d'indexation comme bingbot, ggl , mauibot, semrush, ... il reste préférable d'utiliser la conversion.

Zeloko heu ben si :-) si tu déclare ton document en UTF8 les accents posent problème au moteur d'indexation en général, si tu déclare ton document en charset=iso-8859-1 les commentaires, titre et autre sont correctement lu par ceux ci.

mais ce n'est certainement pas la cause à ton problème actuel juste une idée :-)

Arcantar ben c'est là que je ne te suis pas. Les accents en UTF-8, ça existe. Les séquences &#XXX;, c'est différent de l'encode du fichier. Puisque c'est fait pour être compatible avec l'ASCII.

Ce que je voulais dire plus haut, c'est que dans les deux phrases que tu as indiqué, il y a des accents.

et ben bonne chance je ne comprend rien a tous ces commentaires c du chinois pour moi

Arcantar : pas la peine de débattre la dessus mais je crois vraiment que tu es sur la mauvaise piste.

Les entités n'ont rien à voir avec l'encodage même si elles permettent parfois de palier au problèmes d'affichage des caractères accentués pour des BDD,fichiers ou connexions mal encodés.

Et que ce soit de l'ISO8859 ou de l'UTF8 ça ne change rien tant que tu n'as pas besoin de caractères étrangers.

De mémoire les 126 ou 127 premiers caractères sont identiques. Pour le reste UTF8 est multibyte et pas ISO ce qui lui permet d'encoder tous les caractères de la planète alors que l'ISO ne contient que les caractères latins.

C'est pour ça qu'UTF8 est devenu le standard depuis au moins 2010.

Et pour les moteurs, la spec des entités HTML est plus vieille que HTML, ce qui nous fait remonter au siècle précédent... tu crois vraiment qu'en 20 ans ils n'ont pas trouvé le moyen de les ingurgiter ?

;)

Dalida tu as certainement et entièrement raison Dalida.

c'est exact, l'unicode est parti de l'ascii( non étendu bien sur) donc les 127 premier sont bel et bien identique. concernant la famille des iso8859 de 1 à 15 ( le 8 étant utilisé pour la comparaison sans Diacritics et pour l'hébreu moderne ) ils sont codé sur 1 octet ( soit 8 bits), 1 à 4 ( 1 octet -> 127 puis 2 à 4 pour le million restant) pour l'UTF8 et si on parle bien d'un problème de référencement, le poids d'une page ainsi que son codage fait partie des critères des dits moteurs non ? :-)

20 ans ? ok merci de me rappeler que j'ai commencé par coder des BBS (l'idée qui a généré le minitel en France ;-) ) et suppose , qu'en 20 ans, ces américain's ont réussi à lire l'accentué ;-)

Arcantar même si l'utf-8 va gonfler le poids de la page, je pense que son universalité est meilleure à prendre quand même? Non ?

Rien n'empêche ainsi d'écrire en non latin. Et j'en ai déjà vu passer.

zeloko absolument.

Est-ce que les chiffres diminuent toujours?

Ca n'a plus bougé depuis le 15/04 ;)

Salut à tous

Restes calme Ce n'est qu'une analyse sur 1 mois pour être sur il faut voir sur au moins 3 mois! et ça peut remonter après...ça serait grave si tu vendais quelque chose mais perdre quelques visites provisoirement n'a pas de conséquences graves. Le site reste relativement bien référencé.

Il y a quelquechose qui semble ne pas plaire à google mais quoi?

ton site est paticulairement propre

passé en https

pas de lien douteux sur les images

pas de liens exclus ni douteux

personnellement j'utilise W3C:

validator.w3.org/checklink

pour analyser individuellement chaque url du sitemap et des autres url que google retient.

le seul problème que révèle son analyse ce sont des liens exclus par le robot txt!

Ce qui ne devrait pas faire autant reculer le référencement.

évidemment pour aller plus loin il faudra donner un accès sur google webmaster ou google search à la personne qui se propose pour de l'aide.

Naïvement, j'avais ajouté en blocage dans le robot.txt tout ce qui n'avait pas de sens à être indexé. Mais je sais pas à quel point c'est pénalisant.

J'avoue que ne comprends pas non plus puisque le fichier robot txt est justement fait pour ça et permet à google de faire l'économie de parcourir des url pour rien.

Personnellement après avoir tout nettoyé sur un de mes blogs j'ai la situation suivante :

perte de 17% de visites journalières et en même temps augmentation de 20% de la part des visites par les moteurs de recherche de google...incompréhensible!

sur un autre où je n'ais pas fais le nettoyage:

pertes de 30% de visites et augmentation de 10% de la part des visites par les moteurs de Google on comprends bien l'objectif!

Wait en see...

Que veux-tu dire par nettoyer ?

W3C te liste les liens qui posent des problèmes. le webmaster du site peut alors rechercher où il est dans l'url et ensuite le supprimer ou encore le remplacer par un autre plus approprié.

C'est long et chiant mais indispensable pour se mmaintenir dans le top 10 des recherches du moteur Google. C'est indispensable pour un site de vente en ligne mais très secondaire pour nous les associations personnellement je prends ça comme du sport cérébrale en lieu et place d'une partie de sudoku. Faut être très, très motivé...

Les sociétes de référencement qui font la maintenance payante de sites professionnels ont des contrats qui les obligent à payer de la pub à google quand l'objectif de placement type première ou deuxiéme page garantie n'est pas atteint...

de quoi se faire des couilles en or en ce moment!

Salut,

et d'abord bravo. Bravo d'avoir déjà mis en place une telle stratégie (et suivi !) SEO pour un site opensource et réellement collaboratif ! C'est un très beau projet et je crois qu'une de ses forces (au delà de la communauté qui le constitue) c'est que tu mettes directement les mains dans le code !

testé l'outil Pagespeedqui ne donne pas d'infos particulière

Google propose la recherche par image, celà permet de voir si elles sont bien indexées et les pages rattachées. J'ai fait quelques tests avec les dernières créations qui semblent bien indexées....

voir 1, voir 2, voir 3

Je remarque que

Je propose :

Salut alexb38, merci pour ces retours !

Wep, mais comment faire ça ?

Que veux-tu dire par là ?

dans la searche console, "essayer la nouvelle search console" / couverture de l'index, tu peux télécharger ensuite les données en csv

dans ton premier post tu dis [cite] Pour les images, le lien vers l'image en 1024x1024 est considéré ici [/cite] mais pour cette image, la taille 1024 n'est pas indexée

alexb38, oui, la taille en 1024 n'est jamais directement affichée sur la page. C'est uniquement dans le lien de vue en plein écran ou dans les sitemaps. Du coup, je ne sais pas trop comment la faire connaitre autrement au moteur de recherche ...

Re

Et ce n'est pas fini google annonce encore d'autres contraintes avec le RGPD:

support.google.../answer/7667196

blog.google/to...otection-rules/

Par rapport à perte d indexation, m'a première sujétion et de chercher du côté du passage en HTTPS que semble correspondre au niveau de la date. Il faut savoir que le passage en HTTPS correspond à créer un nouveau site pour Google. Donc à faire : redirection de toutes les urls de http vers HTTPS. Recréer le site dans Google search console, analytics, les sitemaps sont à servir en HTTPS... Les indexation perdues en http sont peut-être reprise sur le site HTTPS mais que tu ne les vois pas dans analytics car ne reprend pas le site HTTPS...

Je me suis peut-être mal exprimé. Le https est actif depuis juin 2016. Ce que j'ai fait depuis mars 2018, c'est de configurer la search console avec (en plus) le lien https du site.

Bon, et bien, je confirme une chose, je ne comprends rien à ce que font les robots Google.

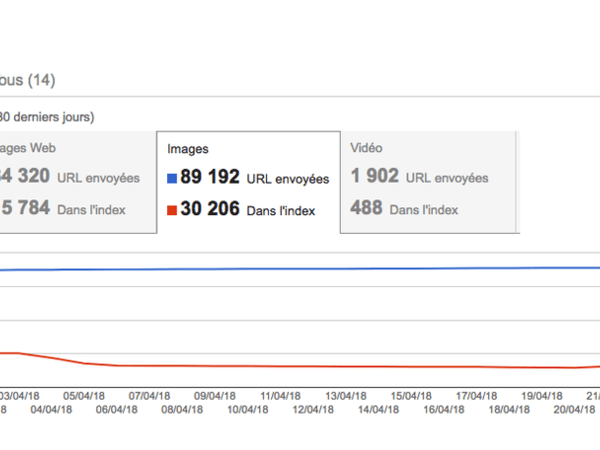

Il y a pour ainsi dire peu ou pas de changements qui ont été faits et l'indexation revient petit à petit ...

Dans 2 mois maxi tu retrouves la normale.

Il a tout réindéxé comme si t'avais changé l'url du sitemap ou relancé la procédure de google webmaster...probablement au passage du http en https en mars 2018?

Peut-être, oui. C'est bête de perdre l'ancienneté des choses dans ce cas.

Et le passage à https s'est fait en 2016 pour le site. Donc, c'est vraiment une affaire de search console. J'avais bien raison de pas vouloir le faire ;)

Hey, Hey !

Les algos apprennent...

Bonne nouvelle en tout cas. Et comme c'est l'heure, je trinque à la santé de l'AdB !